C’est le résumé pour 2009 de Hansen et collaborateurs’, (avec quelques modifications mineures).

“Si ça se réchauffe tant, bon sang, pourquoi fait-il si froid?”

par James Hansen, Reto Ruedy, Makiko Sato, and Ken Lo (Traduction par Xavier Pétillon)

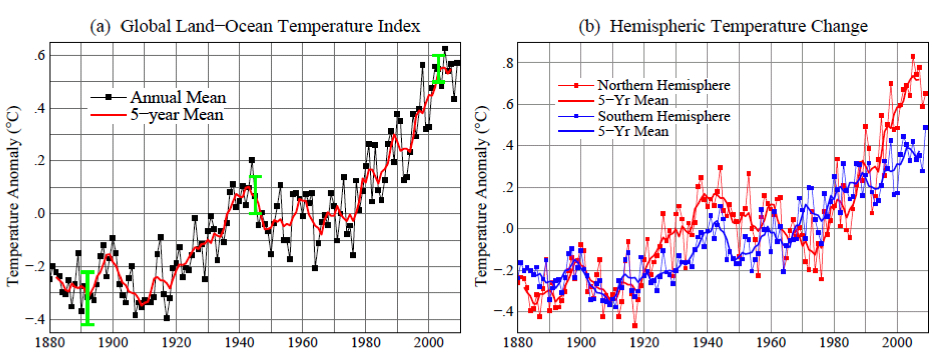

L’année passée, 2009, passe pour être la seconde année la plus chaude depuis 130 ans d’enregistrements instrumentaux de la température globale, dans l’analyse de température de surface par l’Institut Goddard pour les études spatiales de la NASA (GISS). L’hémisphère sud bat un record comme le plus chaud pour cette moitié du monde. La température globale moyenne, comme montré dans l’illustration 1a, fut plus chaude de 0,57°C (1°F) que la période climatologique (période de base 1951-1980). L’hémisphère sud, comme montré dans l’illustration 1b, fut plus chaud de 0,49°C (0,88°F) que la période climatologique.

Illustration 1: (a) analyse du GISS pour les changements de la température globale de surface. La barre verticale verte est l’estimation à l’intervalle de confiance de 95% (deux écarts-type) pour le changement annuel de température. (b) Changement des

températures des hémisphères dans l’analyse du GISS. (Période de base 1951-1980. Cette période de base est est systématiquement fixée pour tous les articles du GISS concernant l’analyse de la température – voir les références. La période de base 1961-1990 est utilisée pour les comparaisons avec les analyses publiées du HadCRUT dans les illustrations 3 et 4).

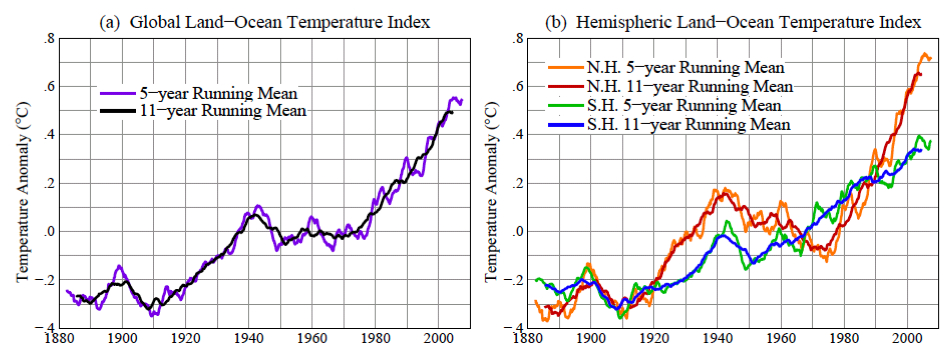

L’enregistrement de l’année globalement la plus chaude, dans la période d’utilisation des mesures instrumentales globales (depuis la fin du XIXème siècle) était 2005. Il est quelques fois avancé que 1998 était la plus chaude. L’origine de cette confusion est discutée ci-après. Il y a un fort degré de variabilité interannuelle (année par année) et décénnale à la fois dans les températures globales et hémisphériques. Sous-tendant cette variabilité, néanmoins, on trouve une tendance au réchauffement de long terme qui devient plus fort et persistant [tenace] au cours des trois dernières décennies. Les tendances de long terme sont plus apparentes quand les températures sont moyennées sur plusieurs années. Les températures en moyennes mobiles sur 60 mois (5 ans) et 132 mois (11 ans) sont montrées dans la figure 2 pour le globe et les hémisphères. La moyenne sur 5 ans est suffisante pour réduire l’effet du cycle climatique tropical El Niño-El Niña. La moyenne sur 11 ans minimise l’effet de la variabilité solaire – la luminosité solaire varie significativement pendant le cycle de tâches solaires, qui est généralement d’une durée de l’ordre de 10-12 ans.

Illustration 2: Températures en moyennes mobiles sur 60 (5 ans) et 132 (11 ans) mois dans l’analyse du GISS pour les changements de température de surface (a) globale et (b) des hémisphères.(période de base 1951-1980).

Il y a une contradiction entre la tendance observée et continue au réchauffement et la perception populaire des tendances climatiques. Ce type de perception inclut fréquemment ces assertions « Il y a eu un refroidissement global ces dernières 10 années. » « Le réchauffement global s’est arrêté en 1998. » « 1998 est l’année la plus chaude jamais enregistrée. » De telles déclarations ont été répétées si souvent que la plupart des gens les acceptent comme vraies. Néanmoins, selon nos données, ces déclarations ne sont pas correctes.

L’origine de la contradiction se trouve probablement pour partie dans la différence entre les analyses du GISS et du HadCRUT (HadCRUT est une association entre le centre Hadley et l’unité de recherche sur l’analyse de température de l’université de East-Anglia). En effet, le HadCRUT a trouvé que 1998 était l’année la plus chaude enregistrée. De plus, les croyances populaires en un refroidissement sont renforcées par des anomalies froides aux USA à l’été 2009 et dans l’hémisphère nord en décembre 2009.

Nous montrerons d’abord les principales raisons des différences entre les analyses du GISS et du HadCRUT. Nous examinerons ensuite les anomalies régionales de 2009 dans le contexte des températures globales.

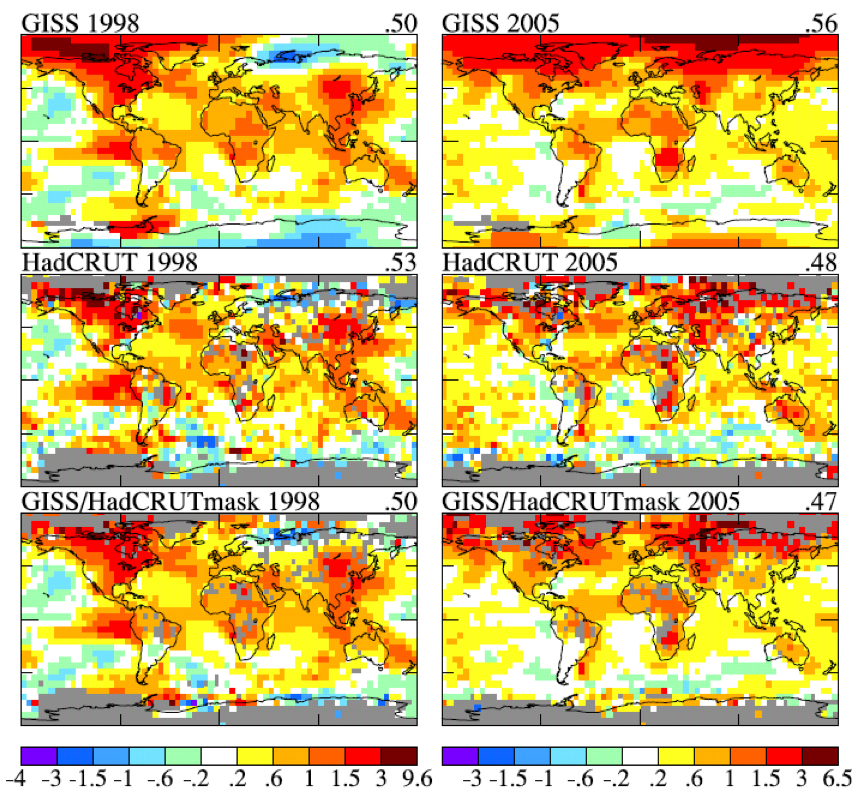

Illustration 3: Anomalies de températures en 1998 (colonne de gauche) et 2005 (colonne de droite). Le rang du haut est l’analyse du GISS, celui du milieu est l’analyse du HadCRUT et le rang du bas est l’analyse du GISS masquée [ndt : calée] sur les mêmes zones et résolution que l’analyse du HadCRUT. (La période de base est 1961-1990.)

L’illustration 3 montre les cartes des anomalies de températures du GISS et HadCRUT en 1998 et 2005 relativement à la période 1961-1990 (la période de base usuelle du HadCRUT). Les anomalies de températures sont dans une résolution de 5 en 5 degrés géographiques pour les données du GISS afin qu’elles correspondent à celles de l’analyse du HadCRUT. Dans les deux cartes du bas, nous montrons les données du GISS sous le même masque en termes de répartition géographique et de résolution que celui du HadCRUT. Les données du GISS « sous masque » nous permettent de quantifier la manière dont les différences entre les analyses du GISS et du HadCRUT sont dues à l’interpolation et l’extrapolation des données utilisées dans l’analyse du GISS. Cette analyse affecte

à de nombreuses cases [des modèles] une anomalie de température qui ne contiennent pas de données mesurées, spécifiquement dans des cases qui se trouvent à moins de 1200 km d’une ou plusieurs stations qui ont défini une anomalie de température.

La raison de cet aspect de l’analyse du GISS est basée sur le fait que le schéma d’une anomalie de température tend à se produire à grande échelle. Par exemple, s’il y a un hiver anormalement froid à New-York, il est probablement anormalement froid à Philadelphie aussi. Ce fait suggère qu’il peut être préférable d’affecter une anomalie de température basée sur les stations les plus proches de la case qui n’a aucune observation que d’exclure la case de l’analyse globale. Des tests de cette assertion sont décrits dans nos articles référencés plus bas.

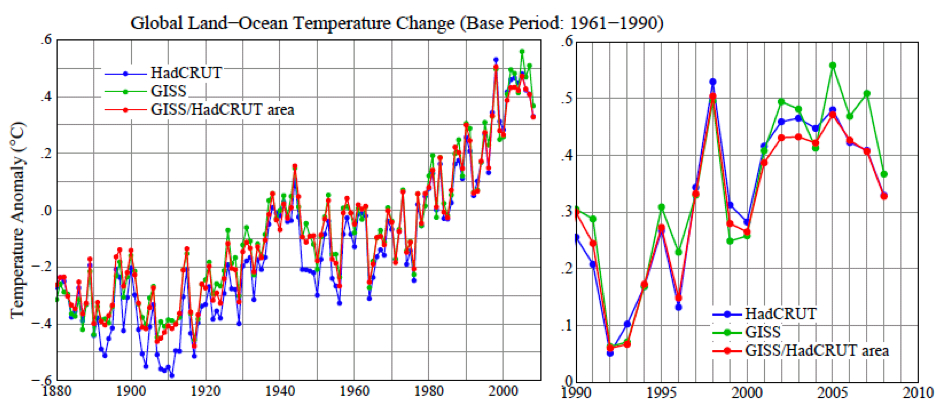

Illustration 4: Anomalies de la température de surface globale relativement à la période de base 1961-1990 pour trois cas : HadCRUT, GISS et anomalies du GISS limitées à l’aire HadCRUT. [Pour obtenir des séries temporelles cohérentes pour les moyennes globales du HadCRUT et du GISS, les résultats mensuels ont été moyennés par régions avec des anomalies de températures définies à l’intérieur de 4 zones de latitudes (90N-25N, 25N-équateur, équateur-25S, 25S-90S) ; la moyenne globale pondère ainsi ces zones en fonction de la vraie surface de ces zones entières, et les moyennes annuelles sont basées sur ces moyennes mensuelles globales.]

L’illustration 4 montre des séries temporelles de température globale pour les analyses du GISS et du HadCRUT, aussi bien que pour l’analyse du GISS masquée sur les régions de données du HadCRUT. Cette illustration révèle que les différences qui se sont développées entre les températures globales du GISS et du HadCRUT ces dernières décennies sont principalement dues à l’extension de l’analyse du GISS à des régions exclues de l’analyse du HadCRUT. Les résultats du GISS et de HadCRUT sont similaires durant

cette période quand les analyses sont circonscrites exactement aux mêmes aires. L’analyse du GISS trouve aussi 1998 comme année la plus chaude, si l’analyse est limité aux données sous le même masque. La question devient alors : quelle est la valeur des interpolations et des extrapolations dans l’analyse du GISS ? Si l’échelle des anomalies de température est ajustée telle que l’anomalie de la moyenne globale est de zéro, alors les schémas des régions chaudes et froides ont un aspect cohérent avec les schémas météorologiques, apportant ainsi un support qualitatif pour l’extension des données. Néanmoins, nous aimerions une mesure quantitative sur l’incertitude de notre estimation pour l’anomalie de la température globale causée par le fait d’une distribution spatiale des mesures incomplète.

Une manière d’estimer cette incertitude, ou possible erreur, peut être d’utiliser les séries temporelles complètes générées par un modèle de climat global ayant déjà fait ses preuves d’une variabilité spatiale et temporelle des températures de surface réaliste. Nous pouvons échantillonner ce jeu de données seulement aux endroits où des stations de mesure existent, et utiliser ce sous-ensemble de données pour estimer le changement de la température globale avec l’analyse du GISS, puis comparer le résultat avec la connaissance « parfaite » de la température globale que nous avons avec les données de chacune des cases.

| 1880-1900 | 1900-1950 | 1960-2008 | |

|---|---|---|---|

| Stations météorologiques | 0.2 | 0.15 | 0.08 |

| Index « Land-Ocean » | 0.08 | 0.05 | 0.05 |

Tableau 1. Estimation de l’erreur à deux écart-type par période pour les stations météorologiques et l’index « Land-ocean ».

Le tableau 1 montre l’erreur dérivée due à la couverture incomplète des stations. Comme attendu, l’erreur est plus importante aux dates anciennes quand la couverture en stations était plus pauvre. Mais aussi, l’erreur est plus grande quand les données sont disponibles seulement depuis les stations météorologiques, sans mesure depuis des bateaux ou satellites pour les aires océaniques. Dans les décennies récentes, l’incertitude à 2 écarts-type (intervalle de confiance à 95% d’être à l’intérieur de ces valeurs, 2 à 3 % d’être en dehors d’un côté ou de l’autre) a été de 0,05°C. La couverture incomplètes des stations est la première cause d’incertitude pour les années récentes, pour lesquelles les erreurs plus systématiques sont petites, comme le réchauffement urbain.

Des sources additionnelles d’erreurs deviennent importantes quand on compare des anomalies de températures séparées par des périodes plus longues. La source d’erreur de long terme la plus connue est « le réchauffement urbain », un réchauffement local d’origine humaine causé par l’utilisation de l’énergie et les altérations de l’environnement naturel. D’autres erreurs variées, qui affectent les estimations des changements de températures sur le long terme, sont décrites de manière complète dans un grand

nombre d’articles par Tom Karl et ses associés du Centre national de données sur le climat (NCDC) de la NOAA. L’analyse du GISS pour la température corrige l’effet urbain en ajustant les tendances de long terme des stations urbaines de manière cohérente avec les stations rurales des alentours, et en identifiant les densités urbaines par leur population ou par l’observation par les satellites des lumières nocturnes. Dans un article en préparation, nous démontrons que les approches par la population et par les lumières nocturnes donne des résultats similaires sur la moyenne globale. Les erreurs additionnelles causées par des facteurs autres que

la couverture spatiale incomplète est estimée comme étant de l’ordre de 0,1°C sur des échelles de temps de plusieurs décennies à un siècle, cette estimation étant nécessairement partiellement subjective. L’incertitude totale dans les anomalies de température globale moyenne, avec les données « terre et océans » ainsi incluses, est équivalente à l’erreur estimée dans la première ligne du

tableau 1, i.e. l’erreur due à une couverture spatiale limitée quand seules les stations météorologiques sont incluses.

Maintenant, voyons voir si nous pouvons préciser un rang entre les températures annuelles globales récentes, i.e. quelle année est la plus chaude, la seconde plus chaude, etc. L’illustration 1a montre l’année 2009 comme la seconde plus chaude, mais si proche de 1998, 2002, 2003 et 2007 que nous devons considérer toutes ces années comme étant virtuellement la seconde année la plus chaude. La différence maximale entre elles dans l’analyse du GISS est de ~0,03°C (2009 étant la plus chaude et 2003 la plus froide). Cet écart est approximativement égal à notre incertitude à un écart-type de ~0,025°C, ce qui est la raison pour établir que ces années sont toutes la seconde année la plus chaude.

L’année 2005 est plus chaude de 0,061°C que 1998 dans notre analyse. Donc, comment sommes-nous certains que 2005 est plus chaude que 1998 ? Étant donné l’écart-type de ~0,025°C pour l’erreur estimée, nous pouvons estimer la probabilité que 1998 était plus chaude que 2005 comme suit. La chance que 1998 soit 0,025°C plus chaude que notre valeur estimée est d’environ (1-0,68)/2=0,16. La chance que 2005 soit 0,025°C plus froide que notre estimation est aussi de 0,16. La probabilité que ces deux évènements se produisent ensemble est de ~0,03 (3 pourcent). Intégrer la queue de distribution et compter une différence de température entre 2005 et 1998 de 0,61°C change l’estimation dans des directions opposées. Pour le moment, disons juste que la chance pour que 1998 soit plus chaude que 2005, étant donnée notre analyse des températures, est au plus de l’ordre de 10 pourcent. Par conséquent, nous pouvons dire avec un degré raisonnable de confiance que 2005 est l’année la plus chaude dans la période de mesures instrumentales.

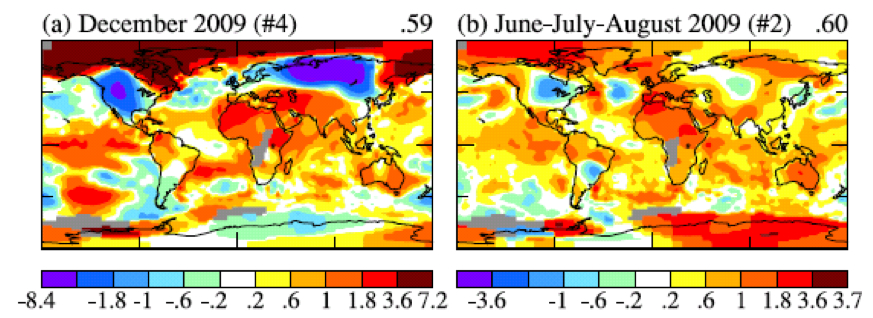

Illustration 5. (a) Carte globale de l’anomalie de décembre 2009, (b) carte globale de l’anomalie de juin-juillet-août 2009. #4 et #2 indiquent que décembre 2009 en juin-juillet-août sont les quatrième et deuxième périodes globalement plus chaudes de ce laps de temps.

Que dire à propos de la déclaration comme quoi la surface de la Terre se rafraîchit depuis 10 ans ? Cette question peut être traitée avec beaucoup de confiance, car l’erreur due à une couverture spatiale insuffisante des mesures devient encore plus faible quand on moyenne sur plusieurs années. L’incertitude à deux écarts-type dans la moyenne sur 5 ans de l’anomalie de température montrée dans l’illustration 2, est plus petite d’un facteur 2 que l’incertitude moyenne annuelle, ainsi 0,02-0,03°C. Étant donné que le changement d’une moyenne sur 5 ans de l’anomalie de température est d’environ 0,2°C sur la dernière décennie, nous pouvons conclure que le monde est devenu plus chaud, et non plus froid, depuis la dernière décennie.

Pourquoi des gens sont-ils convaincus d’une conclusion erronée, que le monde est vraiment en train de se refroidir ? Cette naïveté a certainement beaucoup à voir avec les variations régionales de court terme de la température, qui sont d’un plus grand ordre de grandeur que les anomalies annuelles des températures. Même des personnes non averties sont capables de comprendre la différence entre les anomalies locales [ndt : régionales] de court terme et la tendance globale. Par exemple, voici un commentaire posté par « frogbandit » à 20h38 le 6 janvier 2010 le blog de City Bright :

« Je m’étonne de ces gens qui utilisent une météo quotidienne froide pour dire que la Terre se refroidit. On oublie que le réchauffement global a des composantes globales et que c’est une tendance, pas une chose quotidienne. J’entends des gens, au sud que la latitude 48, dire qu’il fait vraiment froid cet hiver. Ce n’est pas si vrai que ça, ici, en Alaska. Bethel, en Alaska, a eu un Noël brun. Ici, à Anchorage, la température d’aujourd’hui est de 31°F [ndt : soient 3°C]. En me basant sur le fait que Bethel et Anchorage sont si chauds cet hiver, je ne peux pas dire que nous avons un réchauffement climatique. Ce serait vraiment un argument idiot de penser que mon schéma de température est répété dans le reste des Etats-Unis, plus ou moins globalement. »

Ce que ‘frogbandit’ dit est illustré par la carte globale des anomalies de températures en décembre 2009 (illustration 5a). Il y a eu de forte anomalies négatives de températures dans les latitudes moyennes de l’hémisphère nord, pas moins de 8°C en Sibérie, moyenné sur le mois. Mais l’anomalie de température en Arctique était, elle, aussi forte que +7°C.

Le décembre froid confirme peut-être une impression acquise par les américains depuis l’été inhabituellement froid de 2009. Il y avait des régions étendues des USA et du Canada en juin-juillet-août avec une anomalie négative de température supérieure à 1°C, la plus grande anomalie sur la planète.

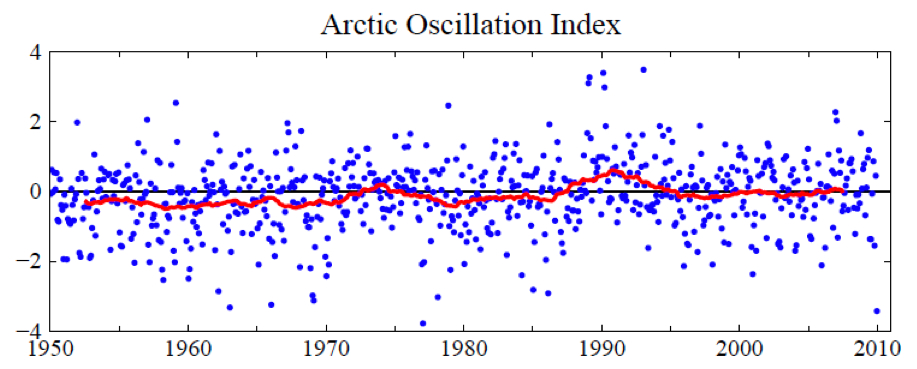

Illustration 6. L’index de l’Oscillation Arctique (AO). Les valeurs positives de l’Index AO indiquent une zone de haute pression sur les régions polaires et ainsi, une tendance à de forts vents zonaux qui minimisent la circulation d’air froid aux latitudes moyennes. Les point bleus sont des moyennes mensuelles et la courbe rouge est la moyenne mobile sur 60 mois (5 ans).

Comment ces larges anomalies régionales de températures se confrontent-elles aux attentes et à la réalité du réchauffement climatique? Ces fluctuations négatives régionales sont-elles inhabituelles? Sont-elles liées avec le réchauffement climatique? Le contredisent-elles?

Il est évident qu’il y a eu en décembre 2009 un échange inhabituel d’air entre le pôle et les latitudes moyennes de l’hémisphère nord. L’air arctique s’est engouffré à la fois sur l’Amérique du nord et l’Eurasie, et, bien sûr, a été remplacé dans ces régions polaires par l’air des latitudes moyennes. La force avec laquelle l’air arctique a pénétré dans les latitudes moyennes est relié avec l’index AO, défini par des schémas de pression atmosphérique de surface et représenté dans l’illustration 6. Quand l’index AO est positif, la pression de surface est élevée dans les régions polaires. Cela permet au jet stream des latitudes moyennes de souffler fortement et constamment d’ouest en est, bloquant ainsi l’air froid au pôle. Quand l’index AO est négatif, il y a une tendance aux basses pressions dans les régions polaires, un vent zonal plus faible, et de plus grands mouvements d’air glacé vers les latitudes moyennes.

L’illustration 6 montre que décembre 2009 a vu la valeur de l’index AO la plus extrêmement négative depuis les années 70. Malgré le fait qu’il y ait eu une dizaine de cas d’index AO aussi extrêmes que -2,5 entre les années 60 et les années 80, il n’y a rien eu d’aussi extrême que le mois dernier. Ce n’est pas étonnant que les gens aient été accoutumés à une absence de ces coups de froid extrêmes.

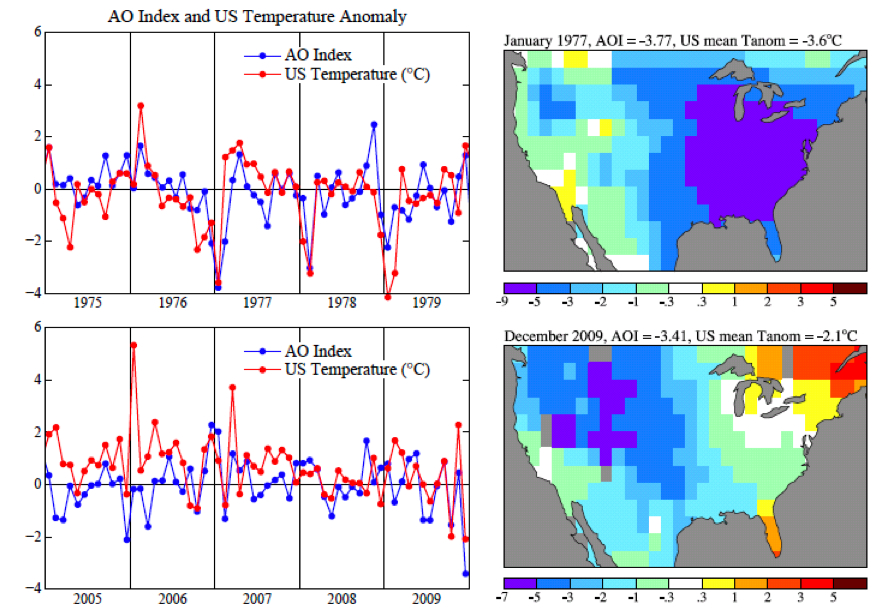

Illustration 7. Anomalie de températures issu de l’analyse du GISS et Index AO du NWSCPC de la NOAA. La moyenne pour les Etats-Unis fait référence aux 48 états contigus.

L’illustration 7 montre l’index AO avec une résolution temporelle plus grande pour deux périodes de 5 ans. Il est évident qu’il y a un fort degré de corrélation entre l’index AO et les températures des Etats-Unis, avec un décalage possible entre l’index et les anomalies de températures inférieur à la résolution termporelle mensuelle. Les anomalies largement négatives, quand elles arrivent, sont souvent pendant les mois d’hiver. Il faut noter que l’anomalie de températures de janvier 1977, principalement située dans les états de l’est, fut considérablement plus forte que celle de décembre 2009. [cela n’a rien de magique quand une fenêtre de 31 jours coincide avec les jours calendaires du mois, et cela peut être trompeur. Il serait plus informatif de regarder la moyenne mobile sur 30 jours et la moyenne de l’index AO et des températures sur décembre-janvier-février.]

L’index AO n’est pas tant une explication pour ces schémas d’anomalies climatiques qu’un simple état de fait de la situation. Cependant, John (Mike) Wallace et ses collègues ont été capable d’utiliser la description de l’index AO pour aider à comprendre comment ces schémas peuvent changer en cas d’augmentation de gaz à effet de serre. Un certain nombre d’articles, par Wallace, David Thompson et d’autres, aussi bien que par Drew Shindell et d’autres au GISS,

ont montré que l’augmentation de gaz carbonique refroidit la stratosphère, ce qui cause en moyenne un jet stream plus puissant, et ainsi une tendance pour une oscillation arctique (AO) plus positive.

Globalement, l’illustration 6 montre une tendance selon le sens attendu. L’AO n’est pas le seul facteur qui altère la fréquence des épisodes d’air froid de l’Arctique. Par exemple, quel est l’effet d’une glace de mer réduite sur le schéma climatologique? Il n’y a pas assez de preuves empiriques depuis la fonte rapide de la glace de 2007. Nous pouvons seulement conclure que décembre 2009 était un mois hautement anormal et que cette oscillation arctique inhabituelle peut décrire la « cause » du climat extrême de décembre.

Nous n’avons pas trouvé de base pour nous attendre à de fréquentes répétitions de ce phénomène. Tout au contraire. L’illustration 6 montre que les fluctuations mois-par-mois de l’AO sont plus étendues que la tendance de long terme. Mais les changements de températures peuvent être causés par les gaz à effet de serre et le réchauffement global être indépendant des effets dynamiques de l’Oscillation Arctique.

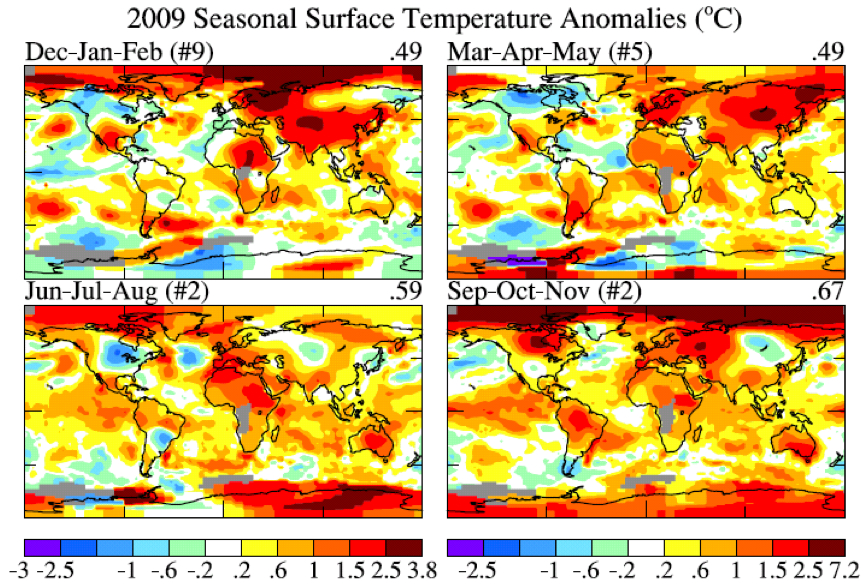

Illustration 8. Carte globale des anomalies de températures pour les 4 saisons pour ~2009. (noter que Dec est décembre 2008. La période de base est 1951-1980.)

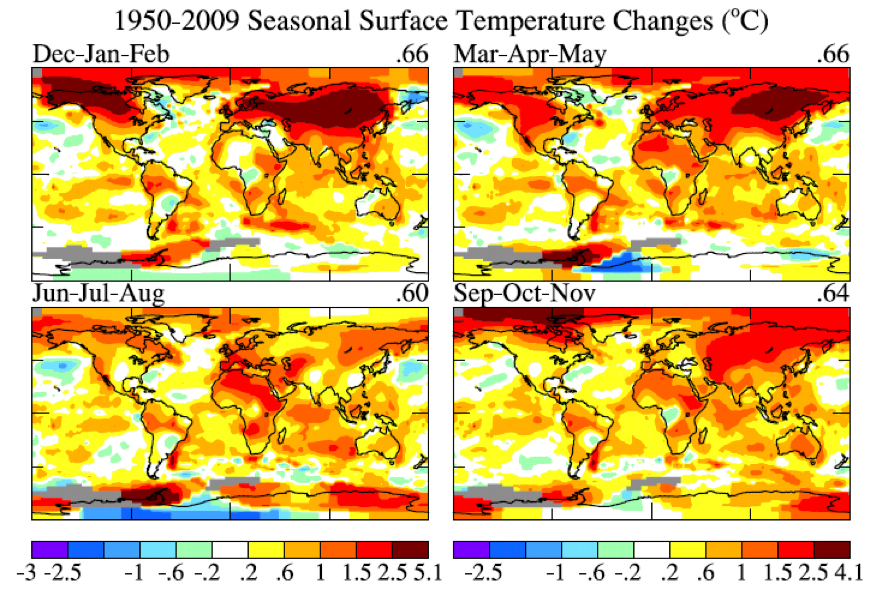

Illustration 9. Carte globale des tendances des anomalies de températures pour les 4 saisons pour la période 1950-2009.

Maintenant, regardons les anomalies de températures régionales récentes et les tendances des températures. L’illustration 8 montre les anomalies de températures saisonnières pour l’année passée et l’illustration 9 montre les changements des anomalies de températures depuis 1950 basés sur une tendance linéaire locale. Les échelles de températures sont les mêmes sur les illustrations 8 et 9. La caractéristique remarquable quand on compare ces deux illustrations est que la magnitude des changements sur 60 ans est similaire à la magnitude des anomalies saisonnières. Ce que cela nous raconte, c’est que les dés climatiques sont déjà sérieusement lancés. La personne perspicace qui est là depuis les années 50 sera capable de noter que les températures moyennes saisonnières sont actuellement plus élevées que celles des années 50, bien qu’il y ait encore occasionnellement des saisons froides.

La magnitude des anomalies mensuelles de températures est couramment 1,5 à 2 fois plus grande que la magnitude des anomalies saisonnières. Du coup, ce n’est pas encore si facile de voir le réchauffement global si sa principale illustration est la température moyenne mensuelle. Et, bien sûr, les fluctuations du temps au quotidien sont bien plus importantes que l’impact de la tendance globale du réchauffement.

Les bases sont celles-ci : il n’y a pas de tendance au refroidissement global.

A l’heure actuelle, jusqu’à ce que l’humanité mette ses émissions de gaz à effet de serre sous contrôle, nous pouvons nous attendre à ce que chaque décennie soit plus chaude que la précédente. Les fluctuations du temps qu’il fait excèdent certainement les changements locaux de températures du dernier demi-siècle. Mais la personne perspicace verra bien que le climat se réchauffe à l’échelle des décennies.

Cette information a encore besoin d’être mise en relation avec la conclusion qu’un réchauffement global de 1 à 2°C a d’énormes implications pour l’humanité. Mais cette discussion est au-delà de la portée de cet article.

Références:

Hansen, J.E., and S. Lebedeff, 1987: Global trends of measured surface air temperature. J. Geophys. Res., 92, 13345-13372.

Hansen, J., R. Ruedy, J. Glascoe, and Mki. Sato, 1999: GISS analysis of surface temperature change. J. Geophys. Res., 104, 30997-31022.

Hansen, J.E., R. Ruedy, Mki. Sato, M. Imhoff, W. Lawrence, D. Easterling, T. Peterson, and T. Karl, 2001: A closer look at United States and global surface temperature change. J. Geophys. Res., 106, 23947-23963.

Hansen, J., Mki. Sato, R. Ruedy, K. Lo, D.W. Lea, and M. Medina-Elizade, 2006: Global temperature change. Proc. Natl. Acad. Sci., 103, 14288-14293.

Bbbbbuttt…. it’s all those temperature gauges sitting right next to air-conditioning exhaust vents!

Oh, wait… this time of year, most of those “air conditioners” are either off or are running in “heat-pump” mode. Never mind….

The big question is — will we get freezing temps again in Edinburg, TX, in the lower Rio Grande Valley this season (latitude 26.3 N)? My husband wants to know if he can plant his vegetable garden. The one he planted earlier froze (which hardly ever happen here).

Mr Hansen you have demonstrated at Fossil Fuel powered electrical generating facilities, and testified for greenpeace activists whom have demonstrated at Fossil Fuel powered electrical generating facilities!

yet to the best of my knowledge neither you or greenpeace support replacement technolgies, why is that ?

[Response: Knowledge about Jim Hansen’s view are best found by reading what he has written on the subject. Try his book, or his plentiful popular science pieces. I can’t speak for Greenpeace, but you are definitely wrong about Hansen. – gavin]

> heat-pump mode

Yeah, see, they’re sucking the heat right out of the thermometers, making it seem colder than it really is. Oh, wait ….

The debate used to be about whether to call it “Global Climate Destabilization” – a much more descriptive term.

From what I read and what I experience, one can say that our climate is destabilized, with more to come. This means extreme, erratic weather events of all kinds – not just heat. Expect stronger storms, wetter rains, dryer droughts, colder cold snaps, and plenty of heat waves.

[Response: This is not something that emerges from the IPCC consensus. You can see from the AO index how hard it is to discern a trend in the mean and to validate that against model expectations, trying to do the same with the variability is much harder and has not been done. Given the link between cold air outbreaks and the AO, one would anticipate fewer cold extremes as a function of the expected positive trend in the AO. The blanket claim that more variability in every index is expected because of ‘climate destabilisation’ is wrong. Statements about extremes of any kind are very specific to exactly what is being discussed and the extent to which any changes are expected needs to be properly sourced. – gavin]

December was .59 degrees C warmer than average. Really? That’s ..well…curious.

It’s nice to see time-linear data presented (at least on occasion) as “running means”. Figure 2 demonstrates their utility in making order out of chaos. As long as the author doesn’t opt for 100-year applications!

Lynn, if you’re serious about that question, you’re a bit muddled, and you’re probably asking the wrong people: you’re asking about the weather, not the climate. If you want an answer, it’s ‘maybe’– if the AO drops through the floor again, arctic air could flow down to your neighborhood again. But the frost you’ve had might just be a one-off; after all, as you said, it’s a pretty rare event.

Can you address this story, in a way that Joe Public can understand?

http://blogs.telegraph.co.uk/news/jamesdelingpole/100022474/climategate-goes-american-noaa-giss-and-the-mystery-of-the-vanishing-weather-stations/

[Response: It’s nonsense born of ignorance of what these analyses do and prejudice against the results. The basic claim is apparently that a coastal station absolute temperature is being used to estimate the current absolute temperature in the mountains and that the anomaly there is warm because the coast is warmer than the mountain. Well, if anyone was doing that, the temperature anomalies would be a lot larger than a few tenths of a degree! What is actually done is that temperature anomalies are calculated locally from local baselines, and these anomalies can be interpolated over quite large distances. This is perfectly fine and checkable by looking at the pairwise correlations at the monthly stations between different stations (London-Paris or New York-Cleveland or LA-San Francisco). The second thread in their ‘accusation’ is that the agencies are deleting records – this just underscores their lack of understanding of where the GHCN data set actually comes from. They could just try reading Peterson and Vose (1997) which indicates where the data came from, and which data streams give real time updates. The principle one is the CLIMAT updates from WMO GCOS. These are distributed by the Nat. Met. Services who have decided which stations they choose to produce monthly mean data for (and how it is calculated) and is absolutely nothing to do with NODC or NASA. – gavin]

Those charts show less than a one degree rise in 130 years. That would seem consistent with pre-industrial centuries preceding this chart.

Ok, disclaimer: I’m a layman, I have a decent amount of general math and science knowledge. BTW, I have just gotten through some very unseasonably cold weather here in South Florida…So I’ve heard the Oh, sooo much for global warming, eh?, cliche so much recently, that I just want to punch people out at this point!

I just took the time to carefully read What Hanson et al have written in this short paper. I’m willing to bet a considerable amount of money that your typical climate change denialist will not even take the time to read a single paper such as this and even if they did they probably don’t have a clue what something as basic as:

means.

Let alone grasp something as basic as the difference between weather and climate.

So you guys must be doing a lousy job getting the true story out to Joe public! ;-)

Just kidding, frustated in Florida!

[Response: Understood, but you need to see that the information conduit is a process. Scientists do their job and produce technically correct statements, and hopefully some context, and then the various levels of popularisers take that information and make pithier and more palatable (though less informative statements) that are nonetheless consistent with the scientific statements. So here, soundbites like ‘it’s weather not climate’, or ‘look globally, not locally’, can follow knowing that there is some factual basis for that. Scientists can of course be popularisers as well, but we can’t neglect the technical stuff that stands behind it. – gavin]

People believe those lies because public relations professionals got those lies placed in front of the public over and over. Even if people doubt a statement, if it is repeated over and over to them from different sources, people will come to accept it.

For such acceptance, the lie must be simple and repeated often. It does not have to be self consistent or consistent with any other knowledge framework.

Scientists are different from public relations professionals because scientists get tired of saying the same thing over and over and over. (RC may say the same thing a few times. Real PR guys would get those things said thousands of times. Folks have to find, and come to RC. Real PR guys would “push it out”, whether people wanted to read it or not.)

Face it, (climate) science just does not “get” the concepts of public relations and mass communications. Science does not market itself or its products. For one thing, science does not have a marketing budget. Imagine writing a grant proposal to do atmospheric research and putting in a line item that was 30% of the total request to “market” the results.

In contrast, the oil companies and car companies really do understand the fine points of marketing. Each of their products has a fully funded marketing budget.

Our marketing program is called “public education”, and it has been under resourced for a long time.

I just came across — and mentioned over at Tamino’s — this year-old story; it looks at the same Arctic weather and ice conditions and at an ocean circulation hiccup. http://www.whoi.edu/page.do?pid=12455&tid=282&cid=54347

Followup there http://tamino.wordpress.com/2010/01/13/models-2/#comment-38598 about modeling generally; just curious if the wind change discussed there is related to this winter’s weather changes.

A useful antidote to the “my drive has more snow than I’ve ever seen” school of climate science.

A future piece on oscillations would be of interest. My understanding is that they explain a lot but cannot themselves be explained.

Regarding Gavin’s response to #5 (extreme weather events), would it be accurate to narrow down and say that more and/or worse droughts and heat waves can be inferred from high-probability IPCC conclusions (though of course not in all locations)?

[Response: Yes. But the regionality of the droughts (in particular) is still poorly defined. – gavin]

What is the diference between the rankings from GISS and NOAA?

http://www.ncdc.noaa.gov/sotc/

[Response: Different treatment for urban heat effects and different procedure for extrapolation to data poor areas. The correlation is pretty high though. – gavin]

“Underlying this variability, however, is a long‐term warming trend that has become strong and persistent over the past three decades.”

Figure 4 undercuts the use of the term “strong” for the last decade of that three-decade period. Unfortunately, this is the sort of imprecise language that causes problems.

Typo Fig. 3 “Temperature anomalies in 1988 (left column)” should be 1998.

[Response: Fixed. Thanks. – gavin]

Looking at GISS hemispheric data, the SH busted all prior 130 years on their record and not by that silly 5th decimal BS “oh 1934 was warmer than 1998, for the United [below Canada] States” margin… 0.489C+ anomaly for 2009, with in second place 2002’s 0.443C+ anomaly. Oceanic heat content starting to come back at us with a vengeance.

I need help in interpreting the statement in the main article: “The AO index is not so much an explanation for climate anomaly patterns as it is a simple statement of the situation. However, John (Mike) Wallace and colleagues have been able to use the AO description to aid consideration of how the patterns may change as greenhouse gases increase. A number of papers, by Wallace, David Thompson, and others, as well as by Drew Shindell and others at GISS, have pointed out that increasing carbon dioxide causes the stratosphere to cool, in turn causing on average a stronger jet stream and thus a tendency for a more positive Arctic Oscillation.”

What I get out of it is that greenhouse gases warm the planet overall, but can also cause artic oscillations that change the pattern of the jet stream and therefore cool portions of the planet affected by the change in the jet stream. Is there an inconsistency in saying that CO2 causes the stratosphere to cool while causing the earth to warm?

“Is there an inconsistency in saying that CO2 causes the stratosphere to cool while causing the earth to warm?”

No, because they do different things.

If you sleep under a thin blanket, the top of the blanket will be warm because of your body and your body cold because of the heat it is letting through.

If you sleep under a thick blanket, the top of the blanket will be cooler because it’s stopping more heat loss and your body warmer because your body is still generating the same heat.

Dr. Hansen: “This information needs to be combined with the conclusion that global warming of 1‐2°C has enormous implications for humanity. But that discussion is beyond the scope of this note.”

That is the reason why the average person isn’t listening. What is an enormous implication? A 1% drop in the stock market? The ONLY thing the average person cares about is the implication for himself. Quit writing “this note” and write about the implications for humanity. The other reasons are the financial clout of the fossil fuel companies, the extreme length of the article and that people want to see blood. Shorten it to a sound byte.

What are people watching almost continuously now? The disaster in Haiti. They get to see dead bodies in Haiti. They like to see dead bodies and flowing blood. Seeing what they want to see it makes them feel guilty, so they “contribute”. Make climate change graphic and gory. Make it bleed. If it doesn’t bleed, it doesn’t lead. Make sure you outdo the story from the earthquake in Haiti. Include lots of pictures of mountains of dead people. Tell them that, if AGW isn’t stopped, THEY will personally be at the bottom of the pile of dead bodies.

Figure 4b will be interpreted by the denialists to mean that AGW stopped in 2000.

realist, did you pick the same conditions at the start of that 130 years as at the end?

1) Solar minimum

2) ENSO minimum, picking up to a warm phase

3) Similar PDO phase

?

If not, you’re comparing apples to oranges. Solar state can make a .2C difference, either end, straight off the top, there, for example. We know we’re at a minimum of solar. What was 1870?

Fred Magyar says: 17 January 2010 at 12:23 PM

Your comment seems consistent with others I’ve read elsewhere.

I’m an enthusiast for this sort of stuff right now, and I still did not take time to wade through the details. Perhaps that’s because I’m fairly confident about my ability to discern weather versus climate, but all the same, it’s a pretty dense essay.

All the same, if anything is left out or is treated ambiguously, doubters will exploit that. So, a bit of a dilemma.

A succinct distillation for consumption by journalists accompanied by a full appendix would be an excellent move.

Russ, I think you got that mixed up. The idea is that a strengthening of the northern jet stream will tend to keep arctic air in the arctic, instead of having it break out into temperate zones. Key phrase there is “tend to”. There will still be cold air outbreaks since there is a natural variation in the AO, and as mentioned, there are other possible influences as well (e.g. arctic ice conditiions).

Here’s another, possibly more user-friendly explanation, in TV form:

http://www.youtube.com/v/sAvqabAPIr4

More great stuff here:

http://www.youtube.com/view_play_list?p=029130BFDC78FA33&search_query=Climate+Crock

Don Shor says:

Figure 4 undercuts the use of the term “strong” for the last decade of that three-decade period. Unfortunately, this is the sort of imprecise language that causes problems.

The “problem”, I would say, is in how you fail to recognize that the statement in the article is referring to a 30 year period, not to any individual 10 year period. Seems pretty clear to me.

According to NOAA, the AO reached a record low since 1950:

“The phase of the AO is described in terms of an index value. In December 2009 the AO index value was -3.41, the most negative value since at least 1950, according to data from the NOAA Climate Prediction Center.”

http://nsidc.org/arcticseaicenews/

However, Figure 6 of this Article indicates a blue dot around 1977 or so that is just about the same as the most recent blue dot. The AO during the 1950’s doesn’t look very negative.

Which one is correct?

Thanks!

Hi there. Thanks for the great post. Informative as always. I just thought I’d point out an excellent blog post I read just yesterday, pointing out in very simple, layman friendly terms, just how difficult it is to identify trends over statistically small samples with such “noisy” data i.e. where local (spatial/temporal) anomalies swamp the trend line.

http://blogs.crikey.com.au/pollytics/2010/01/17/nerdy-sunday-when-trends-go-bad/

Keep up the good work.

Jim Bouldin says: 17 January 2010 at 3:11 PM

“The “problem”, I would say, is in how you fail to recognize that the statement in the article is referring to a 30 year period…”

Jim, remember, the default in a situation of “failure to communicate” is that the communicator failed, not the listener. If an average reader is susceptible to misunderstanding the message, the message could probably use some additional tuning.

Perhaps it would be better if the phrase was “summarizing all of the available data, we see a long‐term warming trend that has become strong and persistent over the past three decades” or something to that effect.

I think some of the problem with the perception among us lay people is the way the charts are drawn. The chart is a rectangle with roughly 3:2 aspect ratio. Using the constraints of the data as the max and min for each axis you have to use extreme compression of the horizontal axis to accommodate 139 years whereas the whole vertical axis is just 1.4 degrees.

I understand that these are the constraints of the data – but it does give the impression of a precipitous rise in temperatures when it actually is only around +0.9 deg C in 129 years. I often think that people look at the chart and think “no, the temperature is not rising that fast!” without actually realising that the global warming signal is just around 0.02c a year hidden within a huge annual variability, such as between -5c and +30c in the UK. I think the statement:

“But the perceptive person should be able to see that climate is warming on decadal time scales.”

is presuming people have some quite miraculous memory for temperatures!

As for myself, my abiding impression of my childhood was that it was much warmer than it is today. Clearly it wasn’t but I think “the perceptive person” is no good judge at all over decadal timescales!

I am not sure what to use as an alternative range for the vertical axis. Perhaps the average variance of temperatures between night and day? The average human being could at least relate to that.

The 11 year running mean does show a very clear linear upward trend – so how does this compare with the predictions of +3 to +6 degrees between 2000 and 2100?

Looking at the chart the current upward trend in temperatures seems to start in the early 1970s. I have taken the data and calculated 11 year running means from 1965 to 2009. This produces the first data point in 1975 which is -0.030c. The last data point, 2009, is +0.608c with an almost straight line between the two points. Using the 11 year running mean as a proxy for the actual data (not sure how valid this is) the difference is 0.638c over 34 annual data points.

That gives an annual rise of 0.01876c a year. Extrapolated over the next 100 years that would give a change of just 1.876c.

Now I am sure the argument is that the models show accelleration in warming as the century progresses. But there is little sign of it yet, and of course that also presumes that the current linear trend continues and that we won’t see any more periods of flat temperature like we saw between 1940 and 1970 at any point in the next 90 years.

Just a few random thoughts…

Re: Cardin #6

The NCDC climate report breaks down December into different areas that Dr. Hansen does. They report that the weather in the US WAS below average. It actually was cold in the USA in December. Dr. Hansen’s data above discusses the GLOBAL average anomaly. The NCDC global anomaly is similar to Dr. Hansen within the limits of the errors Dr. Hansen describes. If you look at figure 5, the anomaly in December for the USA is substantially cold (it is also cold in Siberia). Keep in mind it is Global climate change and you expect there to be regional variations on a monthly basis.

In the post here at RC at:

https://www.realclimate.org/index.php/archives/2009/12/updates-to-model-data-comparisons/comment-page-9/#comment-152359

we see that 10×10^23 Joules went into the oceans from 1985 to 2005. If that had not happened the world atmosphere would be about 7.5 degrees C warmer than it is now.

That would have been easy to see in the data.

“Jim, remember, the default in a situation of “failure to communicate” is that the communicator failed, not the listener.”

True, but you can’t see the lack of lividity over the internet: we can’t tell who are zombies.

And when they’re on the line, the communicator isn’t the problem: zombie ears don’t hear too good.

Using red ink for the loss. If you’ve ever wondered why people don’t trust these graphs, perhaps you should consider using colors that do not make it look like the planet is being parbroiled. This is a bad trick sufficient for inclusion in Lies, Damned Lies, and Statistics.

[Response: Riiiight…. People don’t trust climate scientists because of the colour scheme. Got it. – gavin]

“Now I am sure the argument is that the models show accelleration in warming as the century progresses. But there is little sign of it yet,”

But how many 11 year periods do we have as the century progresses? What is the normal figure for working out non-linear line fitting and therefore seeing an accelleration? 8? 12 periods?

But 11 years isn’t really long enough to show climate, since there’s still plenty of variation by non-persistent causes in those values.

So instead of taking 11 year means and using the fewer plots, check to see what the best-fit accelerating curve fitting that line would be, with all the points used.

That should give you the exponent and therefore how much accelleration you would expect to see.

Roll that back into how many 11-year periods you would have to sample and see if there’s signal appearing above the noise.

If you have enough, but there’s no such acceleration, then the hypothesis is not borne out by your analysis.

If you have enough, and that acceleration is seen, then the hypothesis is seen.

If you haven’t enough, then you can’t say one way or the other. If you do or don’t see that acceleration, then it could easily be a mathematical ghost brought from the analysis.

If you really want to see and there’s not enough time, then you need to get clever with the analysis.

Which requires you think of a physical cause and then model its emergent result on the data.

If you’re going that way, might as well try and get a grant…

Why the obsessive need to explain and justify the GISS readings? It is like an orchestrated campaign of persuasion. If your temperatures are correct then we are in serious trouble should the trend persist. If you are not right and the satellites have the right trend then we have nothing to worry about.

I don’t want to give away my own personal position, suffice it to say that I am NOT worried at all.

Keep up the good work though James. Your people need you.

[Response: Suffice to say your personal position is very clear. However, the satellites also show warming – I fail to see how that means you have nothing to worry about. – gavin]

re: #22 (but for all)

I continue to recommend (for USA), Global Climate Change Impacts in the United States from the USGCRP. It is well-written and illustrated, and in particular, it has a 5-10-page section per region, which is really, really important, given the regional differences in effects.

I think for most people, this is way more impactful than average global temperature changes.

Like: will there be more or less water than I Like?

A: yes, and which depends on where you are…

Foobear:

http://www.fark.com/cgi/comments.pl?IDLink=1092301&hl=Teachers-switch-to-purple-pens-to-correct-papers-since-red-is-too-harsh-Here-comes-pseudo-science

35 Comp.F.U.

What Jim are you talking to?

(comment numbers would help a lot)

“If that had not happened the world atmosphere would be about 7.5 degrees C warmer than it is now.”

Jim, please prove that. If you can point to a couple of papers that show that, this is sufficient, but all I’ve heard is you saying that.

Remember: include all the changes and explain where you may have forgotten something or where your assumptions make a difference.

Sorry, post 35 was to Doug posting about Jim Bullis. Your post from me was (currently) 42.

David Harington says: 17 January 2010 at 3:59 PM

“Why the obsessive need to explain and justify the GISS readings? It is like an orchestrated campaign of persuasion.”

Out of the whole document the one thing that compels a comment from you is a between-the-lines extraction of meaning confirming some kind of conspiracy to mislead the public. Same deal as the TomskTwaddle email dust sieving. It’s amazing how oblivious some folks are to the impression they make; don’t you find yourself a little embarrassed from time to time, blurting out such nonsense?

Completely Fed Up says: 17 January 2010 at 4:26 PM

CFU, I -think- Jim’s point is that there’s a lot of additional energy trapped on the planet that’s hidden from us air breathers. He’s not calling the essay into question.

This is all very nice RC and once again scientifically exact but it won’t wash with a lot of the public regardless of what science says. There is a lot at stake here, out entire way of life to be fair and hence you cant really expect to be listened to all that much. 100,000 people potentially lie dead in Haiti – how did AGW effect them?

It didn’t and hence our cultural way of life is not going to change for a meer 0.8C of global average warmin now is it.

42 Compfu

Ok, there are 10 million meters from equator to pole so area of earth is 5.1×10^14 m^2, volume of a roughly 200 km thick atmosphere is 1.02×10^20 m^3, weight of that atmosphere is 1.33×10^23 grams. Specific heat of air, const. vol., is .24 cal/gm, and 4.186 Joules/calorie. From this, it turns out that it takes about 1.34×10^23 Joules to change the atmosphere 1 degree C. The 10×10^23 Joules that went into the ocean from 1985 to 2005 would raise the air temp by 7.46 degrees C if that energy had gone into the atmosphere instead.

Some of my numbers are rough estimates. As far as explaining where I may have forgotten something, you are joking of course. Maybe I should just say, “The only time I was ever wrong was once when I thought I was wrong.” And I am joking.

But let me put it back on you. Where is there a discussion of how climate models explain how the massive amount of energy got into the oceans as shown in the NOAA chart here at:

https://www.realclimate.org/index.php/archives/2009/12/updates-to-model-data-comparisons/comment-page-9/#comment-152359 ????

David Harrington, do you have any comprehension of how involved an analysis you must perform on the satellite data to get a meaningful lower tropospheric temperature? So what is your basis for preferring these datasets–particularly given their shorter span?

Also, add GISTEMP and it’s trend–how divergent are the slopes of the 3 trends? What does that tell you?

On Harrington nr.38 and the in-line by Gavin… hmmm not worried about what the stats indicate… well eventually the sheep Dolly had to be put out of it’s misery too. Go http://discover.itsc.uah.edu/amsutemps/execute.csh?amsutemps , select near surface, ch04, redraw, tick the 1998, 2002, 2005, 2007, 2009 and 2010 boxes then see what Jan.2010 is looking like :P

Expect Dr.WATTS to studiously comment “As expected …”

What is the scientifically accepted reason for the lack of warming during the 50s and 60s?

“The magnitude of monthly temperature anomalies is typically 1.5 to 2 times greater than the magnitude of seasonal anomalies.”

I don’t understand this statement. The magnitudes of the seasonal anomalies are on the same order as the monthly anomalies; you average the monthlies to get the seasonal.

I’ll accept that the annual means are more noisy than the seasonal means, which are in turn more noisy than the monthly means. Is that what this sentence is trying to say?